Los datos son uno de los activos más valiosos hoy en día, y protegerlos se ha convertido en una prioridad absoluta para las empresas. Como resultado, los sitios web están implementando medidas avanzadas contra el scraping para salvaguardar sus datos. Si desea recopilar datos de forma eficaz, es importante que conozca estas técnicas anti-scraping. En este artículo se describen las técnicas anti-scraping más populares y se explican las formas de evitarlas.

¿Qué es el anti-scraping?

El anti-scraping se refiere a un conjunto de técnicas y herramientas implementadas por los sitios web para evitar la extracción no autorizada de datos. Los sitios web emplean varios métodos para detectar actividades de scraping, como la supervisión del Tráfico entrante en busca de patrones inusuales, como un exceso de peticiones desde una única dirección IP.

Los desafíos CAPTCHA son otro método común utilizado para distinguir entre usuarios humanos y bots automatizados. Estas son sólo algunas de las muchas técnicas anti-scraping que los sitios web utilizan hoy en día. Veamos más en la siguiente sección.

Las 7 técnicas anti-scraping más populares

Exploremos las siete técnicas anti-scraping más populares y las estrategias para superarlas.

1. Lista negra de direcciones IP

Las listas negras de direcciones IP son un método común utilizado por los sitios web para limitar el número de solicitudes que una única dirección IP puede realizar en un periodo de tiempo específico. Esta técnica es muy eficaz para identificar y bloquear a los raspadores que envían demasiadas solicitudes.

En primer lugar, se recomienda no utilizar la dirección IP real para el scraping con el fin de eludir la prohibición de IP. La mejor manera es utilizar la rotación de IP a través de Proxies rotativos premium. Esto implica cambiar frecuentemente la dirección IP para distribuir las peticiones entre varias IPs, reduciendo la posibilidad de detección y bloqueo.

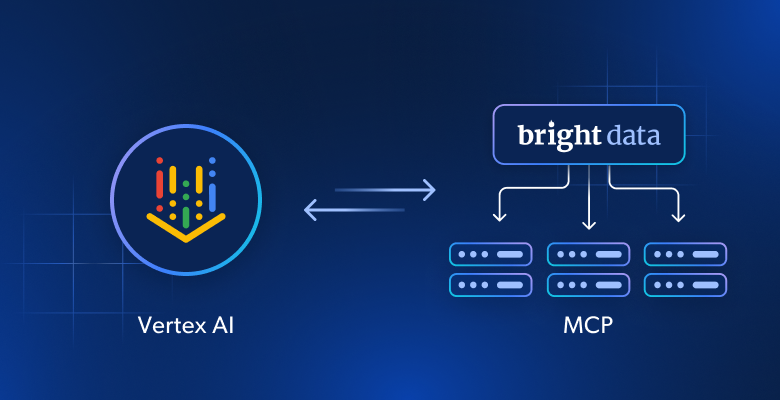

Si necesita Proxies fiables, rápidos y estables para Scraping web, Bright Data ofrece varias opciones adaptadas a diferentes casos de uso. Con millones de IPs proxy residenciales y de centros de datos, Bright Data garantiza soluciones proxy fiables y eficientes.

2. Filtrado de agentes de usuario y otros encabezados HTTP

El filtradodel agente de usuario es otra técnica común contra el scraping. Los sitios web analizan la cadena “User-Agent” en las cabeceras HTTP para diferenciar y bloquear el tráfico no humano. Los raspadores suelen basarse en cadenas User-Agent predeterminadas que son fácilmente detectables por las herramientas anti-scraping.

Del mismo modo, los sistemas anti-scraping pueden bloquear solicitudes que no incluyan una cabecera Referrer, que contiene la URL de la página que inició la solicitud.

Otras cabeceras como Accept-Language, Accept-Encoding y Connection suelen ser enviadas por los navegadores web, pero rara vez las incluyen los raspadores. Los raspadores no suelen tener en cuenta estas cabeceras porque no afectan directamente a la recuperación de contenidos.

Para eludir estas comprobaciones, pueden rotar a través de una lista de cadenas User-Agent que imitan los navegadores y dispositivos más populares e incluir cabeceras adicionales como las comentadas anteriormente.

Sin embargo, los sitios web pueden contrarrestar esto cruzando los datos de User-Agent con otros indicadores de comportamiento como patrones de solicitud y reputación de direcciones IP. Esta técnica requiere actualizaciones constantes de la lista de cadenas User-Agent para seguir siendo eficaz, lo que puede llevar mucho tiempo y ser difícil de mantener.

La solución definitiva para evitar estas complicaciones es utilizar la API Raspador Web de Bright Data. Esta API de raspado de última generación evita sin esfuerzo las tecnologías anti-bot con funciones como la rotación automática de IP, la rotación de User-Agent y los Proxies residenciales. Realizar solicitudes automatizadas con éxito nunca ha sido tan fácil.

3. Desafíos de JavaScript

Los sitios web a menudo utilizan desafíos JavaScript para evitar el scraping automatizado. Estos desafíos pueden incluir CAPTCHAs, carga dinámica de contenido y otras técnicas que requieren la ejecución de JavaScript.

Para hacer frente a estos desafíos, puede utilizar navegadores headless como Playwright o Selenium, que ejecutan JavaScript e interactúan con las páginas web como un usuario humano. Sin embargo, los sistemas avanzados de protección contra bots como Cloudflare y Akamai presentan algunos de los retos de JavaScript más difíciles del mercado. Superar estos retos a menudo requiere dedicar mucho tiempo a juguetear con las herramientas en lugar de centrarse en escribir el raspador. Sin embargo, es posible sortearlos utilizando el Navegador de scraping de Bright Data.

El Navegador de scraping viene con una función incorporada para desbloquear sitios web, que se encarga de gestionar los mecanismos de bloqueo automáticamente. Gestiona todas las operaciones de desbloqueo de sitios web entre bastidores, incluida la Resolución de CAPTCHA, los reintentos automáticos y la selección de encabezados, cookies y renderización de JavaScript adecuados. Además, el Navegador de scraping se integra perfectamente con Puppeteer, Selenium y Playwright, proporcionando una experiencia completa de navegador sin cabeza.

4. Desafíos CAPTCHA

Los CAPTCHAs son un popular sistema de protección anti-bot que requiere que los usuarios completen un desafío para verificar su identidad humana.

Estos retos pueden consistir en identificar objetos en imágenes, resolver rompecabezas o teclear texto distorsionado. Los CAPTCHA son eficaces porque están diseñados para que a los sistemas automatizados les resulte difícil resolverlos.

Muchos servicios CDN(Content Delivery Network), como Cloudflare y Akamai, incorporan ahora CAPTCHAs en sus ofertas de protección anti-bot. Esto ayuda a los sitios web a presentar automáticamente CAPTCHAs a los usuarios sospechosos, especialmente cuando se detectan patrones de tráfico inusuales.

Afortunadamente, se han desarrollado solucionadores de CAPTCHA para resolver este problema. Hay muchos solucionadores CAPTCHA disponibles en el mercado, que hemos discutido en detalle en nuestro artículo, Los 9 mejores solucionadores CAPTCHA para Scraping web. Puede revisarlos en función de factores como la velocidad, la precisión, el precio, los tipos de CAPTCHA que resuelven y la integración de API para encontrar el que mejor se adapte a sus necesidades.

Basándome en mi experiencia, Bright Data Web Unlocker destaca en términos de tasa de éxito, velocidad y capacidad para resolver varios tipos de CAPTCHA. Para más información, puedes consultar la guía detallada sobre Cómo evitar CAPTCHAs utilizando Web Unlocker.

5. Trampas Honeypot

Loshoneypots son una forma sencilla pero eficaz de identificar y bloquear bots poco sofisticados que no son capaces de diferenciar entre contenido visible y oculto. Estas trampas suelen incluir enlaces o formularios ocultos que son invisibles para los usuarios humanos pero detectables por los bots. Cuando un raspador interactúa con un honeypot, hace que el sistema anti-scraping lo bloquee.

Para evitar los honeypots, los raspadores deben analizar cuidadosamente la estructura HTML de las páginas web y evitar interactuar con elementos que no sean visibles para los usuarios humanos, como los que tienen propiedades como "display: none" o "visibility: hidden". Otra estrategia consiste en rotar los proxies, de modo que si una de las direcciones IP del servidor proxy queda atrapada en un honeypot y es baneada, puedas seguir conectándote a través de otros proxies.

6. Análisis del comportamiento

El análisis de comportamiento implica monitorizar las acciones del usuario a lo largo del tiempo para detectar patrones que indiquen un scraping automatizado. Los robots muestran comportamientos predecibles y repetitivos, como realizar solicitudes a intervalos regulares, seguir rutas de navegación inusuales o acceder a páginas en un orden específico. Los sitios web también analizan factores como la duración de la sesión, los movimientos del ratón y el tiempo de interacción para identificar actividades no humanas.

Los sistemas anti-bot avanzados utilizan el aprendizaje automático para adaptarse a las nuevas técnicas de scraping. Mediante el entrenamiento de modelos en amplios Conjuntos de datos de interacciones de usuarios, estos sistemas pueden diferenciar con mayor precisión entre comportamientos humanos y de bots. Este enfoque adaptativo permite que los algoritmos de aprendizaje automático evolucionen en respuesta a la evolución de las estrategias de los bots.

Puede ser difícil eludir estos sistemas, y probablemente necesitará servicios avanzados anti-scraping para mantenerse al día. Web Unlocker es una solución avanzada basada en IA y aprendizaje automático. Está diseñada para abordar y sortear estos bloqueos. Utiliza el aprendizaje automático para determinar los mejores métodos para eludir las defensas de los sitios y emplea algoritmos entrenados para aplicar configuraciones personalizadas de huellas digitales.

7. Huella digital del navegador

La huella digital del navegador es una técnica utilizada por los sitios web para recopilar información sobre su navegador, como la resolución de pantalla, el sistema operativo, el idioma, la zona horaria, las extensiones instaladas y las fuentes. Combinando estos datos, los sitios web pueden crear un identificador único para su dispositivo, que puede utilizarse para rastrear y bloquear a los scrapers. Para evitar la huella digital del navegador, puedes aleatorizar estas características para dificultar que los sitios web creen una huella digital coherente. Para ello, puede cambiar su dirección IP con frecuencia, utilizar diferentes cabeceras de solicitud (incluidos varios User-Agents) y configurar su navegador sin cabeza para utilizar diferentes tamaños de pantalla, resoluciones y fuentes.

Aunque estos métodos pueden funcionar en algunos casos, conllevan riesgos y limitaciones. Para ahorrar tiempo y esfuerzo y garantizar unas operaciones de scraping sin problemas, considere la posibilidad de utilizar herramientas como Bright Data Web Unlocker o Navegador de scraping, que están diseñadas específicamente para gestionar de forma eficaz estos retos.

Conclusión

Este artículo ha cubierto todo lo que necesita saber sobre las técnicas anti-scraping más populares. Comprendiendo estas técnicas e implementando tácticas de evasión avanzadas, podrá extraer datos de sitios web de forma eficaz.

Para más orientación, tenemos una guía detallada sobre Scraping web sin ser bloqueado, donde se discuten varias soluciones para superar las restricciones de sitios web.

Alternativamente, puede agilizar el proceso utilizando el Navegador de scraping de Bright Data o Web Unlocker para acceder a los datos de cualquier sitio web, independientemente de sus restricciones. Comience a utilizar los productos de Bright Data hoy mismo con una prueba gratuita, ¡inscríbase a continuación!