En este artículo trataremos:

- ¿Qué es la extracción de datos?

- Tipos de extracción de datos y fuentes

- Cómo extraer datos

- Cómo la extracción de datos puede ayudar a su negocio

- Las mejores herramientas de extracción de datos

¿Qué es la extracción de datos?

La extracción de datos es el proceso de obtener datos específicos de un conjunto de información, como los datos de código abierto que se encuentran en la web. Este es el primer paso de un proceso que utiliza el acrónimo «ETL»:

- Extraer

- Transformar

- Cargar

Una vez recopilada la información objetivo, como los precios de la competencia y los datos de marketing, se puede analizar y utilizar como inteligencia empresarial (BI) en el proceso de toma de decisiones. Esto puede llevarlo a cabo una parte interesada, como un jefe de equipo que decide cambiar el mensaje de una campaña de marketing, o un algoritmo que actualiza los precios en función de los cambios en tiempo real de la competencia.

Tipos de extracción de datos y fuentes

Los datos pueden provenir de una amplia variedad de fuentes, que son casi tan numerosas como las diferentes metodologías utilizadas para obtener la información deseada.

Tipos de fuentes de datos

Los datos pueden derivarse de actividades internas, como estadísticas sobre la retención y la pérdida de clientes, de bases de datos y archivos gubernamentales, así como de la web.

Fuentes de datos digitales

Los datos recopilados en Internet pueden dividirse en información de identificación personal (PII) e información protegida con contraseña, y es mejor evitar recopilar ambos tipos, ya que es ilegal según las normativas internacionales sobre datos, como el Reglamento General de Protección de Datos (RGPD) en Europa y la Ley de Privacidad del Consumidor de California (CCPA). Ambas se han convertido en estándares del sector y es perjudicial para las empresas, tanto desde el punto de vista legal como desde la perspectiva del consumidor, involucrarse en ellas.

Entre los lugares de código abierto donde se pueden recopilar y aprovechar los datos para obtener valor comercial se incluyen:

- Redes sociales

- Motores de búsqueda

- Sitios web de la competencia

- Foros de debate

- Sitios web gubernamentales

- Archivos históricos

- Mercados de comercio electrónico

Fuentes de datos físicos

El mundo físico genera miles de millones de puntos de datos cada segundo de cada día, entre los que se incluyen:

- Historiales médicos

- Solicitudes de seguros y reclamaciones

- Solicitudes de hipotecas/préstamos

- Datos de transacciones en puntos de venta (PoS)

- Datos de geolocalización generados por los coches en las carreteras o los consumidores en las tiendas

- Datos meteorológicos relativos a las condiciones climáticas y los fenómenos naturales

Tipos de extracción de datos

Los conjuntos de datos pueden ser de muchos tipos, estos son algunos de los más populares:

Uno: Registros de datos completos

Normalmente consisten en todos los puntos de datos de un sitio web determinado. Por ejemplo, todos los proveedores, productos y opiniones de clientes de un mercado electrónico específico.

Dos: Conjuntos de datos diferenciales

Son conjuntos de datos que se actualizan constantemente en función de los valores que han cambiado o se han actualizado desde la recopilación inicial. Pueden incluir precios, número de seguidores (en redes sociales)/empleados, capital inicial recaudado, etc.

Tercero: subconjuntos inteligentes

Incluyen el uso de filtros para acceder a información muy específica que puede ayudar a responder preguntas empresariales o a tomar decisiones informadas. Por ejemplo,«¿Qué está haciendo mal la empresa A?» y«¿Qué podemos hacer nosotros, como empresa de capital riesgo, de forma diferente para crear valor añadido?». Un punto de datos relevante en este caso podría ser la opinión negativa en las redes sociales entre el público millennial sobre los productos de la empresa que no tienen en cuenta el medio ambiente.

Cuatro: Conjuntos de datos enriquecidos

Estos Conjuntos de datos tienen un valor mayor que otros, ya que fusionan información de múltiples fuentes de Internet, lo que permite a las partes interesadas tener una visión más amplia del tema en cuestión. Por ejemplo, cruzar reseñas/opiniones de consumidores de cinco sitios web/foros de debate diferentes.

Cómo extraer datos

En primer lugar, es importante comprender que existen dos categorías principales en lo que respecta a los datos:

Datos no estructurados: son datos en su forma más básica/bruta. Muchas veces incluyen entradas duplicadas o archivos dañados, y se presentan en diversos formatos. Es muy difícil para los sistemas y algoritmos procesar, indexar y utilizar datos en esta forma.

Datos estructurados: son datos en su forma más «pura» y «refinada». Se han eliminado los archivos duplicados y corruptos, y todos los registros de datos se han convertido a un formato uniforme. Es muy fácil para los algoritmos y los sistemas escanear, indexar, analizar y producir resultados valiosos a partir de este tipo de datos.

Cómo extraer datos estructurados/no estructurados

Hay muchas formas de extraer datos estructurados/no estructurados, dependiendo de tus habilidades y recursos. Por ejemplo, si tienes conocimientos de programación, podrías utilizar Python para crear un recopilador personalizado. También podrías utilizar el lenguaje de consulta estructurado (SQL) para organizar y consultar datos en una base de datos relacional.

Sin embargo, para los empresarios que no tienen conocimientos de programación, probablemente lo mejor sea optar por una solución de Scraping web totalmente automatizada, como Web Scraper API. Se trata de una herramienta que limpia, compara, sintetiza, procesa y estructura automáticamente los datos no estructurados antes de entregarlos a sus equipos o sistemas. Estos datos ya están estructurados en el formato que usted elija (JSON, CSV, HTML o Microsoft Excel) y listos para ser analizados.

El proceso de extracción de datos estructurados/no estructurados

Si tiene inclinación por la programación, no dude en consultar nuestra guía de Scraping web con Python. A continuación, le ofrecemos un resumen general de los pasos que conlleva la extracción de datos con Python:

- Paso 1: Elija la URL que desea seleccionar

- Paso 2: Identifique los datos que desea recopilar

- Paso 3: Escriba el código.

- Paso 4: Ejecutar el código para extraer los datos.

- Paso 5: Almacene los datos en el formato necesario.

Para una herramienta automatizada como Web Scraper API, el proceso es el siguiente:

- Elija el sitio web de destino.

- Seleccione la frecuencia de recopilación y el formato de datos que prefiera.

- Reciba los datos en el destino que elija (webhook, correo electrónico, Amazon S3, Google Cloud, Microsoft Azure, SFTP o API).

Cómo puede ayudar la extracción de datos a su negocio

La extracción de datos se puede utilizar de varias maneras para ayudarle:

- Hacer crecer su negocio: por ejemplo, identificando las nuevas necesidades de los usuarios mediante el seguimiento de las tendencias de búsqueda en Google y, a continuación, adaptando las ofertas a esas necesidades.

- Competir de forma más eficaz: ver dónde están ganando más terreno sus competidores entre el público (por ejemplo, en las redes sociales), así como qué productos tienen las tasas de conversión más altas, lo que le permitirá dar un giro.

- Optimizar las campañas de marketing: las empresas pueden aprovechar la opinión social de la plataforma e incorporar mensajes receptivos en las campañas.

- Inteligencia de inversión: las entidades de inversión pueden realizar un seguimiento de las noticias, la opinión pública y las actividades financieras corporativas de código abierto para predecir con mayor precisión el movimiento del mercado de valores en determinados títulos.

Los mayores retos a los que se enfrentan las empresas con la extracción de datos

Algunos de los mayores retos a los que se enfrentan las empresas al intentar extraer datos son:

- La falta de conocimientos técnicos en materia de programación y/o la falta de personal cualificado para la extracción de datos (DevOps/TI/programadores, etc.).

- Incapacidad para crear, adquirir y mantener el hardware y el software necesarios para llevar a cabo de forma eficaz operaciones de recopilación de datos en tiempo real.

- Incapacidad para recopilar, limpiar, procesar y analizar datos en un plazo que realmente ayude a crear «valor en el momento», de modo que los responsables de la toma de decisiones puedan optimizar las campañas basándose en las actividades actuales de la competencia y los consumidores.

Las mejores herramientas de extracción de datos

Existen muchas herramientas de extracción de datos. Algunas son mejores que otras; entre los factores relevantes a tener en cuenta se incluyen la calidad de los datos, las fuentes de datos, las direcciones IP y los pares. Debe tener mucho cuidado al elegir con qué proveedor de datos trabajar, asegurándose de que le vendan información de calidad y actualizada que se haya obtenido de forma legal para garantizar el valor a largo plazo de sus productos y servicios basados en datos.

Los productos de Bright Data emplean estándares líderes en el sector en lo que respecta a la recopilación ética de datos. Todos los pares de nuestra red tienen la opción de participar o no a su propia discreción, además de recibir una compensación completa por la participación de sus dispositivos en nuestras redes de recopilación de datos.

Contamos con un equipo dedicado que se encarga del cumplimiento en tiempo real, incluyendo la prevención basada en códigos y los mecanismos de respuesta tecnológica.

Por último, todas las actividades de recopilación de datos cumplen al 100 % con las leyes internacionales sobre datos, incluidos el Reglamento General de Protección de Datos (RGPD) y la Ley de Privacidad del Consumidor de California (CCPA).

Las dos herramientas más populares entre las empresas líderes del sector son:

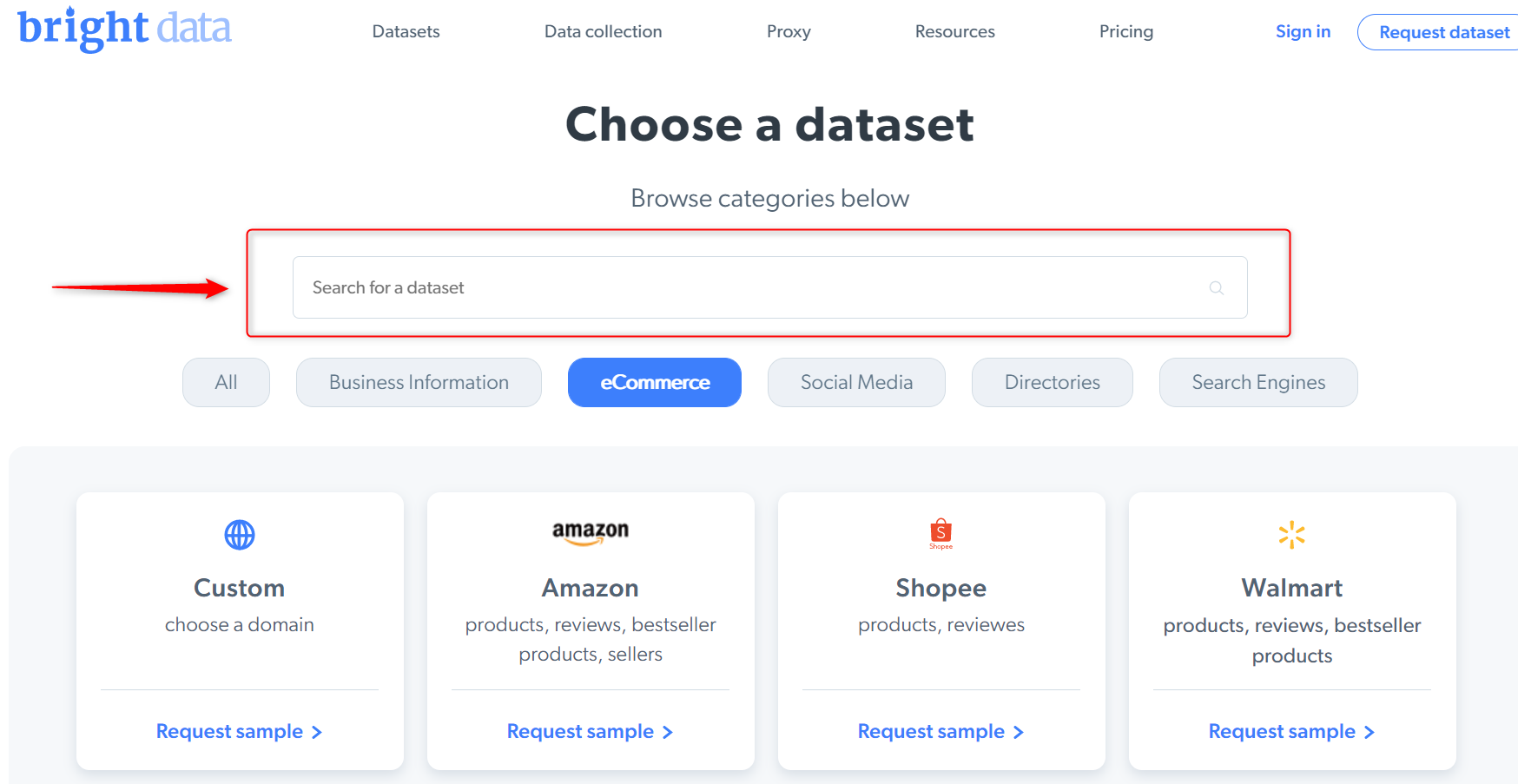

Conjuntos de datos

Se trata de Conjuntos de datos pre-recogidos y listos para usar que se pueden solicitar y obtener en cuestión de minutos. Todo lo que tiene que hacer es elegir el conjunto de datos al que desea acceder y recibirlo directamente en su equipo/algoritmos.

API de Web Scraper

La API de Web Scraper es una herramienta totalmente automatizada que permite a los empresarios sin conocimientos técnicos acceder a un flujo de datos en tiempo real sin necesidad de programar. Limpia y sintetiza la información objetivo, y envía puntos de datos estructurados directamente a los equipos y algoritmos designados.

Conclusión

La extracción de datos es hoy en día una opción líder para la recopilación y el análisis de datos masivos, y está ayudando a empresas y particulares a mejorar sus servicios y su conocimiento de las expectativas de los clientes o proyectos. Aunque la extracción de datos se puede realizar sin la ayuda de terceros, la externalización del proceso puede ayudar a ahorrar dinero y tiempo, que se pueden dedicar a asuntos empresariales más urgentes.