En este artículo, vamos a hablar de:

- Qué son las API de investigación y sus principales tipos

- Las 11 mejores API comparadas por rendimiento y precio

- Cómo elegir la más adecuada para sus necesidades

- Retos técnicos y mejores prácticas

- Por qué Bright Data lidera la tasa de éxito más alta

TL;DR: Las mejores API de investigación de un vistazo

| API | Tipo | Nivel gratuito | Precio inicial | Ideal para |

|---|---|---|---|---|

| Bright Data | Scraping web | Prueba disponible + 5000 solicitudes MCP gratuitas | 0,98 $/1000 registros (con promoción) | Investigación empresarial |

| Linkup | Búsqueda web | 5 € de crédito/mes (~1000 consultas) | 5 €/1000 consultas | Aplicaciones de IA/LLM |

| SerpAPI | SERP | 250 búsquedas/mes | 75 $/mes (5000 búsquedas) | Investigación SEO |

| ScrapingBee | Scraping web | 1000 pruebas gratuitas | 49 $ al mes | Extracción personalizada |

| Tavily | Búsqueda con IA | 1000 créditos/mes ✓ | 0,008 $/crédito ✓ | Investigación con IA |

| Exa | Semántica | 10 $ en créditos gratis | 5-25 $/1000 solicitudes | Descubrimiento de investigación |

| Apify | Scraping web | 5 $ de créditos para la plataforma al mes | Pago por uso | Flujos de trabajo escalables |

| Serper | SERP (Google) | 2500 consultas ✓ | 50 $/50 000 consultas (1 $/1000) | Proyectos solo para Google |

| SearchAPI | SERP | 100 solicitudes gratuitas ✓ | 40 $/mes (10 000 búsquedas) | Proyectos económicos |

| ScraperAPI | Scraping web | 1000-5000 créditos gratuitos | 49 $ al mes ✓ | Desafíos antibots |

| Búsqueda Brave | Búsqueda web | 5 $ de crédito al mes (cambio reciente) | 5 $/1000 solicitudes | Investigación centrada en la privacidad |

Los investigadores, los científicos de datos y las empresas dependen cada vez más de las API para recopilar datos web a gran escala. Tanto si se trata de rastrear citas académicas, supervisar a la competencia o alimentar modelos de IA con información en tiempo real, la API de investigación adecuada puede ahorrar cientos de horas de trabajo manual.

Pero con docenas de opciones disponibles, elegir la adecuada no es sencillo. Las tasas de éxito varían enormemente. Los modelos de precios confunden incluso a los desarrolladores experimentados. Y las medidas contra los bots evolucionan constantemente.

Esta guía compara las 11 mejores API de investigación en 2026, desglosando sus puntos fuertes, limitaciones y casos de uso ideales. Encontrará datos de rendimiento reales, comparativas de precios y orientación práctica para tomar la decisión correcta.

¿Qué son las API de investigación?

Las API de investigación son herramientas que extraen datos de sitios web, motores de búsqueda o bases de datos académicas mediante programación. En lugar de copiar manualmente la información o crear complejos Scrapers desde cero, estas API se encargan del trabajo técnico pesado.

Una API de investigación típica gestiona la rotación de proxies, evita la detección de bots, realiza la resolución de CAPTCHAs y devuelve datos estructurados en formatos como JSON o CSV. Esta automatización permite a los investigadores centrarse en el análisis en lugar de en la infraestructura de recopilación de datos.

Tipos de API de investigación

Las API de investigación se dividen en tres categorías principales, cada una de las cuales satisface necesidades diferentes:

Las API SERP se especializan en extraer páginas de resultados de motores de búsqueda. Devuelven datos estructurados de Google, Bing y otros motores de búsqueda, incluidos resultados orgánicos, anuncios, fragmentos destacados y preguntas relacionadas. Estas API destacan en la investigación de SEO, el seguimiento de posiciones y el análisis de palabras clave.

Las API de scraping web ofrecen una mayor flexibilidad. Pueden extraer datos de prácticamente cualquier sitio web: plataformas de comercio electrónico, redes sociales, sitios de noticias o bases de datos académicas. Estas API gestionan la representación de JavaScript, la rotación de Proxies y las medidas antibots en diversos sitios de destino.

Las API de búsqueda web potencian las aplicaciones de IA y LLM con datos web en tiempo real. Están optimizadas para los procesos de generación aumentada por recuperación (RAG), proporcionando contenido limpio y estructurado que los modelos de IA pueden procesar directamente.

Cómo funcionan las API de investigación

Cuando envías una solicitud a una API de investigación, se producen varios procesos entre bastidores. La API selecciona un Proxy adecuado de su grupo de proxies, configura las huellas digitales del navegador para que parezcan humanas y enruta tu solicitud a través de una infraestructura diseñada para evitar la detección.

Si el sitio de destino presenta un CAPTCHA, la API lo resuelve automáticamente. Si una solicitud falla, la lógica de reintento integrada intenta enfoques alternativos. La respuesta HTML sin procesar se analiza en datos estructurados y usted recibe una salida JSON o CSV limpia.

Todo este proceso suele completarse en 5-15 segundos, dependiendo de la complejidad del sitio de destino y de la calidad de la infraestructura de la API.

¿Por qué utilizar API de investigación?

La recopilación manual de datos no es escalable. Copiar información de sitios web lleva horas, introduce errores y no puede seguir el ritmo de los datos que cambian rápidamente. Las API de investigación resuelven estos problemas y permiten enfoques de investigación completamente nuevos.

Automatización de la investigación académica

Los investigadores académicos utilizan las API para rastrear citas, analizar tendencias de publicación y supervisar temas de investigación emergentes. Por ejemplo, un investigador de sociología que estudia la desinformación puede necesitar analizar miles de publicaciones en redes sociales cada día. La recopilación manual sería imposible, pero una API lo convierte en una tarea rutinaria.

El análisis de redes de citas presenta retos similares. Para trazar las relaciones entre artículos académicos es necesario extraer datos de Google Scholar, PubMed y repositorios institucionales. Las API de investigación gestionan estas fuentes a gran escala, al tiempo que gestionan las medidas antibots que bloquean los Scrapers básicos.

Estudio de mercado e inteligencia competitiva

Las empresas supervisan a sus competidores mediante la recopilación sistemática de datos. Las API de investigación permiten realizar un seguimiento de los cambios en los precios, los lanzamientos de productos, las opiniones de los clientes y el posicionamiento en el mercado de sectores enteros.

Una empresa minorista puede realizar un seguimiento de los precios de 50 competidores para 10 000 productos. Las alertas en tiempo real se activan cuando los competidores ajustan los precios, lo que permite una respuesta rápida. Este nivel de supervisión requiere una infraestructura de API de nivel empresarial que gestione millones de solicitudes de forma fiable.

SEO y análisis SERP

La optimización de motores de búsqueda depende de datos de clasificación precisos. Las API SERP rastrean las posiciones de las palabras clave, supervisan los fragmentos destacados y analizan las estrategias de contenido de la competencia. Estos datos impulsan decisiones de contenido que valen millones en tráfico orgánico.

Las grandes agencias realizan un seguimiento de miles de palabras clave en cientos de dominios de clientes. La comprobación manual requeriría equipos de analistas; las API SERP automatizan todo el proceso con actualizaciones cada hora o cada día.

Recopilación de datos de IA/LLM

Los grandes modelos de lenguaje y las aplicaciones de IA necesitan información actualizada para proporcionar respuestas precisas. Las API de investigación alimentan los procesos RAG (Retrieval-Augmented Generation) con datos web en tiempo real, basando los resultados de la IA en fuentes fácticas y actualizadas.

Los agentes de IA utilizan cada vez más las API de búsqueda web para recopilar información antes de responder a las consultas. Este enfoque combina las capacidades de razonamiento de los LLM con la frescura y la precisión de los datos web en tiempo real.

API SERP frente a API de búsqueda web frente a API de Scraping web

Comprender las diferencias entre los tipos de API le ayuda a elegir la herramienta adecuada. Cada categoría se optimiza para diferentes casos de uso, y los desajustes provocan un desperdicio de recursos o resultados inadecuados.

Diferencias clave

Las API SERP extraen los resultados sin procesar de los motores de búsqueda con alta fidelidad. Obtienes exactamente lo que aparece en Google o Bing, incluidos anuncios, fragmentos destacados, paneles de conocimiento y listados orgánicos. El resultado está muy estructurado, lo que lo hace ideal para herramientas de SEO y seguimiento de posicionamiento.

Las API de búsqueda web dan prioridad al contenido preparado para la IA. A menudo limpian y resumen las páginas web, eliminando los elementos de navegación y los anuncios para ofrecer contenido que los LLM pueden procesar de manera eficiente. Algunas mantienen índices de búsqueda propios en lugar de rastrear los motores existentes.

Las API de Scraping web ofrecen la mayor flexibilidad. Pueden dirigirse a cualquier sitio web, no solo a motores de búsqueda, y manejar escenarios complejos como sesiones autenticadas, páginas de desplazamiento infinito y aplicaciones con mucho JavaScript. Esta flexibilidad conlleva más requisitos de configuración.

¿Cuál debería elegir?

Elija una API SERP si necesita datos estructurados de motores de búsqueda para SEO, investigación de palabras clave o análisis de la competencia. Estas API ofrecen la vía más limpia para acceder a los datos de clasificación y las funciones de búsqueda.

Elige una API de búsqueda web si estás creando aplicaciones de IA que necesitan conocimientos web en tiempo real. Estas API se integran directamente con los marcos LLM y se optimizan para los procesos RAG.

Elige una API de Scraping web si tus objetivos van más allá de los motores de búsqueda. La supervisión del comercio electrónico, el análisis de las redes sociales, la extracción de bases de datos académicas y los proyectos de investigación personalizados suelen requerir la flexibilidad de las API de Scraping web.

Muchos proyectos de investigación se benefician de la combinación de tipos de API. Un asistente de investigación de IA podría utilizar una API de búsqueda web para consultas generales y una API de Scraping web para profundizar en fuentes de datos específicas.

Las 11 mejores API de investigación en 2026

Después de probar el rendimiento, analizar los precios y evaluar la documentación de los principales proveedores, estas 11 API se revelaron como las mejores opciones para casos de uso de investigación.

1. Bright Data (la mejor en general)

Bright Data ofrece la solución API de investigación más completa, combinando las tasas de éxito líderes en el sector con la mayor red de Proxies disponible. La plataforma se encarga de todo, desde simples consultas SERP hasta complejas extracciones de comercio electrónico, sin necesidad de configurar Proxies ni ajustes antibots.

Puntos fuertes clave:

- Tasa de éxito del 98,44 %, la más alta entre los proveedores probados en pruebas independientes.

- Más de 150 millones de IPs residenciales en 195 países

- Más de 120 Scrapers listos para usar para sitios populares (no se requiere código).

- Selección automática de proxies, Resolución de CAPTCHA y lógica de reintento

- Precio fijo: 1,50 $/1000 solicitudes (estándar).

Ideal para: equipos de investigación empresariales que necesitan una recopilación de datos fiable y escalable de diversas fuentes. La combinación de Scrapers listos para usar y acceso API personalizado se adapta tanto a usuarios técnicos como no técnicos.

Limitaciones: muchos productos y servicios, puede resultar difícil encontrar el más adecuado por uno mismo.

2. API de búsqueda web Linkup (ideal para IA/LLM)

Linkup creó su API específicamente para aplicaciones de IA. Las integraciones nativas con LangChain, LlamaIndex y MCP (Model Context Protocol) la convierten en la forma más rápida de añadir capacidades de búsqueda web a proyectos LLM.

Puntos fuertes clave:

- Diseñada específicamente para canalizaciones RAG y agentes de IA

- Índice de búsqueda propio (no se basa en Google)

- 5 € por cada 1000 consultas estándar, rentable para un uso intensivo de IA

- Integraciones nativas del marco LLM

- Capacidad de 10-100 consultas por segundo

Ideal para: desarrolladores de IA que crean chatbots, asistentes de investigación o cualquier aplicación que requiera conocimientos web en tiempo real. La arquitectura nativa de IA elimina la fricción en la integración de LLM.

Limitaciones: Limitado a casos de uso de búsqueda, no se pueden extraer datos de sitios web arbitrarios. Es posible que el índice propio no coincida con la cobertura de Google para consultas específicas.

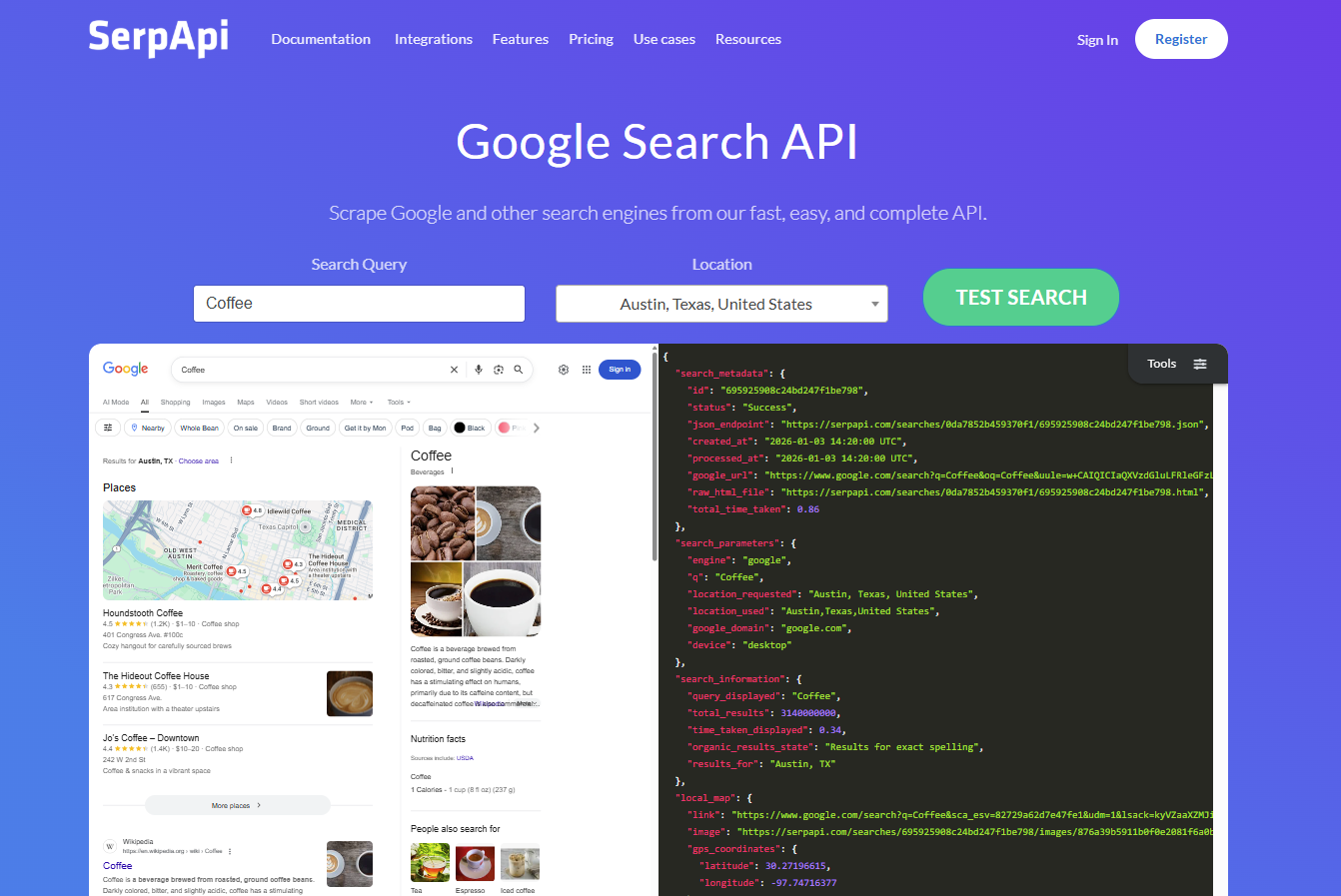

3. SerpAPI (API SERP rápida)

SerpAPI ha establecido el estándar para la extracción estructurada de datos de motores de búsqueda. Su excelente documentación, su salida JSON coherente y su amplia cobertura de motores de búsqueda lo convierten en la opción preferida para herramientas de SEO y análisis SERP.

Puntos fuertes clave:

- Salida JSON estructurada de Google, Bing, Yahoo y más

- Compatibilidad con Google Scholar para la investigación académica.

- 250 búsquedas gratuitas al mes para empezar (antes eran 100)

- Documentación completa con ejemplos de código

- A partir de 75 $ al mes por 5000 búsquedas

Ideal para: profesionales de SEO, investigadores de palabras clave y desarrolladores que crean herramientas relacionadas con la búsqueda. La salida estructurada elimina los dolores de cabeza del Parseo.

Limitaciones: centrado únicamente en SERP, no apto para el Scraping web general. Los costes aumentan rápidamente con volúmenes elevados en comparación con las alternativas de tarifa plana.

4. ScrapingBee (bueno por su flexibilidad)

ScrapingBee ofrece a los desarrolladores un control total sobre la lógica de extracción, al tiempo que se encarga de la rotación de proxies y la representación del navegador. Esta flexibilidad se adapta a proyectos de investigación personalizados con requisitos únicos.

Puntos fuertes clave:

- Control total sobre los parámetros de extracción

- Renderización JavaScript con Chrome sin interfaz gráfica

- Rotación de proxies entre IPs residenciales y de centros de datos

- Captura de pantallas y generación de PDF

- A partir de 49 $ al mes por 150 000 créditos API

Ideal para: desarrolladores que necesitan un control preciso sobre el comportamiento del scraping. Los proyectos de investigación académica personalizados y la extracción de datos especializados se benefician de la flexibilidad de ScrapingBee.

Limitaciones: Requiere más conocimientos técnicos que las soluciones llave en mano. Usted es responsable del parseo lógico y la gestión de errores más allá de lo que proporciona la API.

5. Tavily (una gran opción para la investigación en IA)

Tavily se optimiza específicamente para aplicaciones de investigación en IA, ofreciendo resúmenes de contenido y extracción de datos integrados. La API devuelve fragmentos listos para IA en lugar de HTML sin procesar.

Puntos fuertes clave:

- Formato de respuesta optimizado para IA

- Resumen automático de contenidos

- Extracción de datos integrada

- Nivel gratuito: 1000 créditos al mes

- Pago por uso: 0,008 $ por crédito

Ideal para: Investigadores que desarrollan herramientas de análisis o sistemas de contenido basados en IA. Las funciones de resumen ahorran una cantidad significativa de trabajo de posprocesamiento.

Limitaciones: el precio basado en créditos puede encarecer los proyectos de gran volumen. Menos flexible que las API de scraping de uso general para casos de uso no relacionados con la IA.

6. Exa (la mejor búsqueda semántica)

Exa utiliza la búsqueda neuronal para encontrar contenido semánticamente similar, yendo más allá de la coincidencia de palabras clave. Este enfoque destaca en el descubrimiento de investigaciones relacionadas, la búsqueda de empresas similares o la exploración de espacios temáticos.

Puntos fuertes clave:

- Capacidades de búsqueda neuronal/semántica

- Funcionalidad «Buscar similares» para el descubrimiento de contenido

- Resaltado y extracción de contenido

- Eficaz para casos de uso de descubrimiento de investigaciones

- Diseño de API fácil de usar para desarrolladores

Ideal para: Investigación, análisis competitivo y sistemas de recomendación de contenido. El enfoque semántico encuentra resultados relevantes que la búsqueda por palabras clave no encuentra.

Limitaciones: Índice más pequeño que el de los principales motores de búsqueda. Es mejor como complemento de la búsqueda tradicional que como sustituto.

7. Apify (óptimo para escalabilidad)

Apify combina un mercado de Scrapers preconstruidos con una infraestructura para ejecutar actores personalizados a gran escala. La plataforma se encarga de la programación, el almacenamiento y la supervisión de flujos de trabajo de scraping complejos.

Puntos fuertes clave:

- Mercado con miles de Scrapers preconstruidos

- Infraestructura en la nube para ejecutar código personalizado

- Programación y almacenamiento integrados

- Sólida comunidad y documentación

- Opciones de pago por uso y suscripción

Ideal para: equipos que ejecutan múltiples flujos de trabajo de scraping y se benefician de la gestión centralizada. El mercado acelera el desarrollo para casos de uso comunes.

Limitaciones: Curva de aprendizaje para el desarrollo de actores personalizados. Los costes pueden ser impredecibles para flujos de trabajo complejos con un uso variable de los recursos. El rendimiento varía significativamente entre los diferentes actores.

8. Serper (el mejor solo para Google)

Serper se centra exclusivamente en Google y ofrece un acceso rápido y asequible a los resultados de búsqueda. Su enfoque específico permite un rendimiento optimizado y una tarificación sencilla.

Puntos fuertes clave:

- Especializado en Google para un rendimiento optimizado

- Tiempos de respuesta rápidos (una media de ~2 segundos)

- Precios sencillos y predecibles a partir de 50 $ al mes por 50 000 consultas

- Salida JSON limpia

- 2500 consultas gratuitas para empezar

Ideal para: proyectos que solo necesitan datos de Google y dan prioridad a la velocidad y la rentabilidad. El enfoque específico elimina la complejidad.

Limitaciones: Solo Google, sin Bing, Yahoo u otros motores. Flexibilidad limitada para proyectos que se expanden más allá de la búsqueda de Google.

9. SearchAPI (la mejor opción en cuanto a asequibilidad)

SearchAPI ofrece precios competitivos en múltiples motores de búsqueda, lo que lo hace accesible para proyectos de investigación y startups con presupuestos ajustados.

Puntos fuertes clave:

- Compatibilidad con múltiples motores (Google, Bing, Baidu y más)

- Asequible, desde 40 $ al mes por 10 000 búsquedas

- Datos SERP en tiempo real

- Diseño sencillo de la API

- Buena documentación

Ideal para: Startups e investigadores individuales que necesitan datos SERP sin presupuestos empresariales. La compatibilidad con múltiples motores añade flexibilidad.

Limitaciones: una infraestructura más pequeña que la de los líderes del mercado puede afectar a la fiabilidad a gran escala. Menos funciones avanzadas que las alternativas premium.

10. ScraperAPI (la mejor infraestructura de Proxy)

ScraperAPI destaca su infraestructura de Proxy, que ofrece una sólida rotación de IP y capacidades de segmentación geográfica. El enfoque en la calidad del Proxy se adapta a proyectos en los que evitar los bloqueos es el principal reto.

Puntos fuertes clave:

- Rotación y gestión sólidas de proxies

- Opciones de segmentación geográfica

- Compatibilidad con la representación de JavaScript

- API sencilla con reintentos automáticos

- A partir de 49 $ al mes

Ideal para: proyectos dirigidos a sitios con medidas antibots agresivas, donde la calidad del Proxy determina el éxito. El enfoque en la infraestructura ofrece fiabilidad.

Limitaciones: Menos especializada para casos de uso específicos como SERP o IA. Puede requerir un desarrollo más personalizado para necesidades de extracción complejas. Los multiplicadores de crédito pueden aumentar significativamente los costes en sitios protegidos.

11. Brave Search API (la mejor en materia de privacidad)

Brave mantiene un índice de búsqueda independiente, que ofrece una alternativa a las API dependientes de Google. El enfoque centrado en la privacidad resulta atractivo para los investigadores preocupados por las prácticas de datos.

Puntos fuertes clave:

- Índice de búsqueda independiente (no extrae datos de Google)

- Prácticas de datos centradas en la privacidad

- 5 $ de crédito gratuito al mes (cubre ~1000 consultas)

- Búsqueda en la web, noticias e imágenes

- Clasificación transparente sin personalización excesiva

Ideal para: Investigadores preocupados por la privacidad y proyectos que requieren una fuente de datos independiente. Los créditos gratuitos permiten realizar pruebas significativas y proyectos a pequeña escala.

Limitaciones: Índice más pequeño que el de Google, lo que significa posibles lagunas en la cobertura. Puede que no coincida con los resultados de Google para investigaciones comparativas.

Cómo elegir la API de investigación adecuada

Con 11 opciones sólidas, la selección depende de la adecuación de las capacidades de la API a sus requisitos específicos. Hay cuatro factores que son los más importantes: adecuación al caso de uso, modelo de precios, necesidades de escalabilidad y requisitos de calidad de los datos.

Considere su caso de uso

Comience por identificar sus fuentes de datos principales y sus necesidades de salida.

Para la investigación SERP y SEO: SerpAPI o Serper proporcionan datos de búsqueda estructurados optimizados para el análisis de posicionamiento. Bright Data ofrece capacidades SERP dentro de una solución más amplia.

Para aplicaciones de IA/LLM: Linkup y Tavily se integran directamente con los marcos LLM. Sus resultados optimizados para IA reducen los requisitos de posprocesamiento.

Para el Scraping web general: Bright Data, ScrapingBee o Apify gestionan diversos objetivos. Los Scrapers listos para usar de Bright Data aceleran los casos de uso comunes.

Para investigación académica: tenga en cuenta las tasas de éxito en fuentes académicas. La fiabilidad del 98,44 % de Bright Data minimiza las lagunas de datos. La compatibilidad de SerpAPI con Google Scholar sirve para el análisis de citas.

Evalúa los modelos de precios

Los precios de las API varían considerablemente en cuanto a estructura y coste total. Comprender estos modelos evita sorpresas en el presupuesto.

Los precios de tarifa plana (Bright Data: 1,50-2,50 $/1000 solicitudes) ofrecen previsibilidad. Sabrá exactamente cuánto le costarán 100 000 solicitudes antes de empezar.

Los multiplicadores de crédito complican la elaboración del presupuesto. Algunas API cobran entre 5 y 75 veces las tarifas básicas por la representación de JavaScript, los sitios premium o la geolocalización. Un precio nominal de 0,001 $/solicitud puede convertirse en 0,075 $ en la práctica.

Los niveles de suscripción (SerpAPI, Serper, SearchAPI) agrupan volúmenes de solicitudes fijos a tarifas mensuales. Estos se adaptan a necesidades predecibles y de volumen moderado.

Los precios basados en el uso (Linkup, Tavily) se escalan linealmente con el consumo. Esto funciona bien para cargas de trabajo variables, pero requiere supervisión.

Calcule los costes reales utilizando el volumen previsto, la complejidad del objetivo y los requisitos de las funciones. Tenga en cuenta las tasas de reintento: una API más barata con un 90 % de éxito puede costar más que una más cara con un 98 % de éxito después de tener en cuenta las solicitudes fallidas.

Compruebe la escalabilidad y los límites de velocidad

Los proyectos de investigación suelen crecer más allá de las estimaciones iniciales. Verifique que la API elegida pueda escalarse.

Los límites de solicitudes simultáneas determinan el rendimiento. Bright Data gestiona volúmenes empresariales; los proveedores más pequeños pueden limitar el rendimiento a cientos de solicitudes simultáneas.

Los límites diarios/mensuales en los niveles gratuitos y de entrada restringen las pruebas y el uso en producción. Asegúrese de que existen vías de actualización sin cambios importantes en la arquitectura.

La calidad de la infraestructura afecta a la fiabilidad bajo carga. Las API respaldadas por millones de IP (Bright Data: más de 150 millones) mantienen el rendimiento a medida que aumenta el volumen.

Evalúe la calidad y la estructura de los datos

Las tasas de éxito brutas no lo dicen todo. Tenga en cuenta lo que recibe cuando las solicitudes tienen éxito.

El formato de salida es importante para el procesamiento posterior. Las respuestas JSON se integran fácilmente con las herramientas de análisis; el HTML sin procesar requiere parseo.

La integridad de los datos varía según el proveedor. Algunas API omiten contenido dinámico, elementos cargados con AJAX o contenido detrás de interacciones.

La coherencia determina si se pueden comparar los datos de forma fiable a lo largo del tiempo. Las API con formatos de salida estables simplifican la investigación longitudinal.

Casos de uso de API de investigación

Las diferentes aplicaciones de investigación tienen requisitos distintos. Estos desgloses de casos de uso ayudan a adaptar las API a necesidades específicas.

Análisis de citas académicas

Las redes de citas mapean las relaciones entre publicaciones, revelando tendencias de investigación y artículos influyentes. Esto requiere extraer datos de Google Scholar, bases de datos académicas y repositorios institucionales.

Requisitos clave: alta tasa de éxito en fuentes académicas, salida estructurada para el análisis de redes, capacidad para manejar la paginación en miles de resultados.

Recomendado: Bright Data por su fiabilidad y escala; SerpAPI por sus datos estructurados de Google Scholar.

Seguimiento de tendencias

El seguimiento de temas emergentes requiere una recopilación continua de datos de fuentes de noticias, redes sociales y publicaciones del sector. Las alertas en tiempo real permiten responder rápidamente a las noticias de última hora.

Requisitos clave: velocidad para actualizaciones casi en tiempo real, amplia cobertura de fuentes, programación y entrega fiables.

Recomendado: Bright Data por su cobertura completa y fiabilidad empresarial.

Inteligencia competitiva

Comprender el posicionamiento de la competencia requiere una recopilación sistemática de datos: precios, catálogos de productos, mensajes de marketing, opiniones de clientes y presencia en el mercado.

Requisitos clave: éxito del sitio de comercio electrónico, extracción estructurada de datos de productos, cobertura geográfica para precios regionales.

Recomendado: los Scrapers de comercio electrónico listos para usar de Bright Data y su red de más de 150 millones de IP.

Recopilación de datos para el entrenamiento de IA

Los grandes modelos de lenguaje y los sistemas de IA necesitan datos de entrenamiento diversos y de alta calidad. Las API de Scraping web proporcionan la escala y la variedad necesarias para obtener conjuntos de entrenamiento eficaces.

Requisitos clave: capacidad de volumen (millones de páginas), calidad y diversidad del contenido, prácticas de recopilación de datos conformes.

Recomendado: Bright Data por su escala y fiabilidad; Linkup por su integración nativa para IA.

Estudio de mercado

Para comprender la dinámica del mercado se necesitan datos de múltiples fuentes: informes del sector, documentos de empresas, cobertura de noticias y opiniones de los consumidores en diferentes plataformas.

Requisitos clave: amplia cobertura de sitios web, capacidad para extraer datos estructurados de diversos formatos, entrega fiable para programas de investigación continuos.

Recomendado: Bright Data por sus capacidades integrales; Apify para la gestión del flujo de trabajo.

Seguimiento del posicionamiento SEO

El seguimiento de las posiciones de búsqueda por palabras clave y competidores impulsa la estrategia de SEO. Los datos precisos y coherentes de SERP permiten medir el rendimiento y realizar análisis competitivos.

Requisitos clave: salida SERP estructurada, coherencia histórica, segmentación geográfica para búsquedas locales.

Recomendado: SerpAPI o Serper para capacidades SERP dedicadas; Bright Data API SERP para necesidades empresariales.

Retos técnicos y soluciones

Las API de investigación existen porque el Scraping web se enfrenta a importantes barreras técnicas. Comprender estos retos le ayuda a evaluar las capacidades de las API y a establecer expectativas realistas.

Detección antibots y CAPTCHA

Los sitios web modernos implementan sofisticados sistemas de detección. Estos analizan las huellas digitales del navegador, los patrones de solicitud, los movimientos del ratón y docenas de otras señales para identificar el acceso automatizado.

El reto: la detección activa bloqueos, CAPTCHAs o datos engañosos. Los scripts simples fallan en los sitios protegidos en cuestión de minutos.

Cómo lo resuelven las API: los proveedores premium cuentan con equipos de investigación de detección que actualizan continuamente las huellas y los comportamientos. La selección automática de parámetros de Bright Data se encarga de estos ajustes sin necesidad de configuración por parte del usuario, logrando un 98,44 % de éxito en diversos objetivos.

Limitación de velocidad

Los sitios limitan las tasas de solicitud para gestionar la carga del servidor y desalentar el scraping. Superar los límites provoca bloqueos temporales o permanentes.

El reto: los límites de velocidad varían según el sitio, la hora del día y la reputación de la IP. Alcanzar los límites interrumpe la investigación y puede quemar direcciones IP.

Cómo lo resuelven las API: distribución inteligente de solicitudes entre enormes grupos de IP. Los más de 150 millones de IP de Bright Data permiten un alto rendimiento sin superar los límites de cada sitio. La lógica de reintento integrada gestiona los bloqueos temporales con elegancia.

Parseo y limpieza de datos

El HTML sin procesar contiene navegación, anuncios, scripts y formato junto con el contenido de destino. La extracción de datos útiles requiere una lógica de parseo compleja.

El reto: las estructuras HTML cambian sin previo aviso, lo que rompe los analizadores. Mantener el código de extracción para múltiples sitios web exige un esfuerzo de desarrollo continuo.

Cómo lo resuelven las API: los Scrapers listos para usar (Bright Data ofrece más de 120) devuelven JSON estructurado para sitios comunes. La extracción basada en IA gestiona sitios sin analizadores dedicados. Estos enfoques eliminan la mayor parte del mantenimiento del parseo.

Mejores prácticas para el uso de API de investigación

Para maximizar el valor de las API de investigación es necesaria una implementación cuidadosa. Estas prácticas mejoran los resultados y controlan los costes.

Comience con pruebas gratuitas

Cada API funciona de manera diferente en sus objetivos específicos. Los niveles y pruebas gratuitos le permiten probar el rendimiento en el mundo real antes de comprometer su presupuesto.

Ejecute sus casos de uso reales durante las pruebas. Extraiga datos de sus sitios objetivo, pruebe los volúmenes esperados y compruebe que los formatos de salida se ajustan a sus necesidades. Las especificaciones teóricas importan menos que los resultados medidos.

Implemente el manejo de errores

Incluso una tasa de éxito del 98 % significa un 2 % de fallos. Un manejo de errores robusto evita las lagunas de datos y el desperdicio de créditos.

Implemente un retroceso exponencial para los reintentos. Registre los fallos para su análisis: los patrones revelan objetivos problemáticos o problemas de configuración. Diseñe flujos de trabajo para gestionar los resultados parciales con elegancia.

Optimice la rentabilidad

Las pequeñas optimizaciones se acumulan a gran escala. La reducción de solicitudes innecesarias mejora directamente el retorno de la inversión.

Almacene en caché las respuestas cuando la actualidad de los datos lo permita. Agrupe las solicitudes cuando las API lo permitan (Bright Data gestiona 5000 URL por lote). Cuando sea posible, apunte a elementos específicos de la página en lugar de a renderizaciones de página completa.

Supervise el uso en relación con el valor. Realice un seguimiento del coste por información en lugar del coste por solicitud. Una API premium que proporcione datos utilizables puede costar menos que una barata que requiera un posprocesamiento extenso.

Por qué Bright Data es la mejor API de investigación

Tras un análisis exhaustivo, Bright Data se perfila como la API de investigación líder para la mayoría de los casos de uso. Cinco factores llevan a esta conclusión:

Fiabilidad inigualable: la tasa de éxito del 98,44 % no es marketing, sino el rendimiento medido en diversos objetivos en pruebas de referencia independientes. Para la investigación que depende de datos completos, esta fiabilidad evita lagunas que comprometen el análisis.

Escala masiva: más de 150 millones de direcciones IP en 195 países proporcionan una infraestructura que gestiona volúmenes empresariales sin degradación. Tanto si necesita 1000 como 100 millones de solicitudes, la plataforma ofrece un rendimiento constante.

Precios transparentes: los precios de tarifa plana (1,50 $ estándar, 2,50 $ premium por cada 1000 solicitudes) eliminan la complejidad del multiplicador de créditos que afecta a la competencia. Conoces los costes antes de empezar, lo que te permite presupuestar el proyecto con precisión.

Configuración cero: la selección automática de Proxies, la huella digital del navegador y la lógica de reintento funcionan sin necesidad de ajustes manuales. Usted se centra en las cuestiones de investigación mientras Bright Data se encarga de la infraestructura técnica.

Solución completa: más allá de la API Web Scraper, Bright Data ofrece API SERP, redes de Proxy, Conjuntos de datos listos para usar y scrapers sin código. Un único proveedor cubre todas las necesidades de datos de investigación.

Para los investigadores que necesitan datos fiables a escalas importantes, Bright Data ofrece la solución más completa y fiable del mercado.

Conclusión

La elección de la API de investigación adecuada depende de sus necesidades, presupuesto y requisitos técnicos.

Bright Data destaca para la mayoría de los equipos con su tasa de éxito del 98,44 %, su red de más de 150 millones de IP y sus precios transparentes. Se adapta tanto a proyectos sencillos como a implementaciones empresariales.

Para aplicaciones de IA, Linkup y Tavily ofrecen integraciones LLM nativas que reducen el tiempo de desarrollo.

Para el trabajo de SEO, SerpAPI y Serper proporcionan los datos SERP más estructurados y fiables.

Para los equipos que se preocupan por el presupuesto, SearchAPI (40 $ al mes) y Serper (50 $ al mes) ofrecen un valor sólido, mientras que los créditos mensuales gratuitos de Brave Search permiten realizar pruebas sin coste alguno.

Comience con pruebas gratuitas para validar el rendimiento en sus objetivos reales. Pruebe a fondo y elija la API que le proporcione datos fiables para sus casos de uso específicos.

Preguntas frecuentes sobre las API de investigación

¿Qué son las API de investigación?

Las API de investigación son herramientas que extraen datos de sitios web, motores de búsqueda o bases de datos académicas mediante programación. Se encargan de los Proxies, las medidas antibots y el Parseo de datos, lo que permite la recopilación automatizada de datos de investigación a gran escala.

¿Cuál es la mejor API para el Scraping web de datos de investigación?

La API Web Scraper de Bright Data es la mejor en general, con una tasa de éxito del 98,44 %, más de 150 millones de IP y una fiabilidad de nivel empresarial. Para necesidades específicas de IA, Linkup ofrece integraciones LLM nativas.

¿Cuál es la diferencia entre las API SERP y las API de Scraping web?

Las API SERP extraen resultados estructurados de motores de búsqueda (HTML/JSON) específicamente de Google, Bing y otros motores de búsqueda. Las API de Scraping web ofrecen una extracción flexible de cualquier sitio web con Proxy rotativo y funciones antibots. Las API SERP son especializadas; las API de Scraping web son generalizadas.

¿Cuánto cuestan las API de investigación?

Los precios oscilan entre 0,005 € por consulta (Linkup) y 2,50 $ por 1000 solicitudes (sitios premium de Bright Data). La mayoría de los proveedores ofrecen planes iniciales de entre 40 y 75 $ al mes con entre 5000 y 250 000 solicitudes. Tenga en cuenta los multiplicadores de crédito que aumentan los costes efectivos entre 5 y 75 veces en algunas plataformas.

¿Necesito Proxies para extraer datos de investigación?

Sí, los proxies y la rotación de IP son esenciales para evitar las prohibiciones y los CAPTCHA en la mayoría de los sitios. Las principales API, como Bright Data, gestionan esto automáticamente con más de 150 millones de pools de IP, lo que elimina la necesidad de gestionar los proxies por tu cuenta.

¿Qué API de investigación tiene la tasa de éxito más alta?

Bright Data alcanzó una tasa de éxito del 98,44 % en pruebas independientes realizadas por Scrape.do, la más alta entre los principales proveedores. La plataforma alcanza un 100 % de éxito en dominios específicos de alto valor, como Indeed, Zillow, Capterra y Google.

¿Pueden las API de investigación manejar sitios web con mucho JavaScript?

Sí, las API de investigación modernas incluyen capacidades de renderización de JavaScript mediante navegadores sin interfaz gráfica. Bright Data, ScrapingBee y ScraperAPI admiten la ejecución completa de JavaScript, aunque la renderización suele aumentar el tiempo de solicitud y puede afectar al precio.