En este artículo aprenderemos sobre:

- Los retos a los que se enfrentan los desarrolladores cuando los datos scrapeados de sitios web no son fiables o están desactualizados.

- Identificar las causas de los malos resultados del scraping

- Obtener sugerencias para garantizar datos más limpios y fiables

¡Vamos a ello!

Algunas causas de la inexactitud de los datos de Scraping web

Antes de aprender cómo mejorar la precisión de sus datos raspados, necesita conocer algunas de las causas de estos problemas. En esta sección aprenderá algunos de los problemas que puede encontrar al raspar. Algunos de ellos son el contenido dinámico, los cambios frecuentes en el DOM, etc.

Contenido renderizado en JavaScript que crea vacíos de datos

Los sitios web con mucho JavaScript cargan el contenido de forma asíncrona después de la respuesta HTML inicial, lo que deja a los raspadores HTTP tradicionales con estructuras de página incompletas. Cuando se solicita una página, sólo se recibe el esqueleto HTML inicial antes de que se ejecute JavaScript. Los listados de productos en sitios de comercio electrónico, los comentarios de los usuarios en plataformas sociales y el contenido de desplazamiento infinito suelen cargarse mediante llamadas AJAX que se producen milisegundos o segundos después de la carga de la página.

Este desajuste temporal hace que los raspadores extraigan elementos de marcador de posición, rotadores de carga o contenedores vacíos en lugar de datos reales. El HTML raspado puede contener <div class="product-list" data-loading="true"></div> en lugar de la información de producto rellenada.

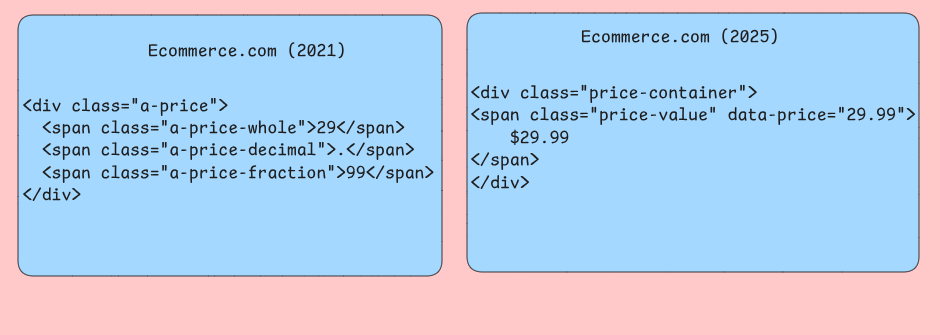

Evolución incoherente de la estructura DOM

Los sitios web modifican con frecuencia su estructura HTML sin mantener la compatibilidad con herramientas automatizadas. Es posible que tengan selectores CSS que han funcionado de forma fiable durante meses y que, de repente, devuelvan resultados vacíos cuando los desarrolladores cambian los nombres de las clases, reestructuran los diseños o mueven elementos a contenedores padre diferentes. Su Raspador podría apuntar a selectores .product-price que cambian de nombre a .item-cost durante el rediseño de un sitio web.

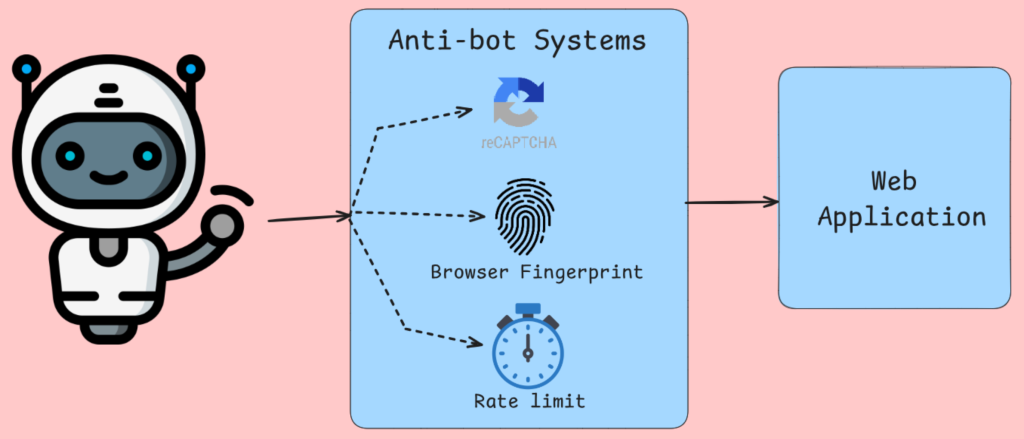

Los sistemas anti-bot corrompen la recopilación de datos

La detección de bots no se limita al bloqueo de IP, el análisis de las huellas dactilares del navegador, los movimientos del ratón y otras comprobaciones bien conocidas. Herramientas como Cloudflare y servicios similares inyectan retos JavaScript que requieren la ejecución del navegador para completarse. Tras la comprobación del navegador, se le servirán contenidos alternativos o páginas de error a las solicitudes que no superen estas pruebas. Su Raspador recibe páginas CAPTCHA, mensajes de acceso denegado o datos deliberadamente engañosos en lugar de contenido legítimo.

Los algoritmos de limitación de velocidad rastrean la frecuencia de las solicitudes por dirección IP, cadena de agente de usuario, etc. Con esta información, el Tráfico es estrangulado o bloqueado si parece una actividad humana.

Problemas de renderizado en el servidor

La renderización en el servidor con frameworks como Next.js, genera diferentes resultados HTML basados en diferentes criterios. La misma URL puede devolver estructuras de contenido completamente diferentes dependiendo de factores que su Raspador no controla o simula con precisión. El contenido personalizado, la información geolocalizada y los precios específicos para cada usuario crean situaciones en las que su raspador ve datos diferentes a los de los usuarios previstos.

Las capas de almacenamiento en caché entre su raspador y los servidores de origen introducen incoherencias temporales en las que el contenido recientemente actualizado tarda en propagarse a través de los nodos CDN. Su raspador podría recuperar precios de productos obsoletos, niveles de inventario desactualizados o páginas de error almacenadas en caché que no reflejan el estado actual del sitio web. Los servidores Edge de distintas regiones geográficas pueden servir versiones en caché diferentes, lo que hace que la coherencia de los datos dependa del servidor que responda a sus solicitudes.

Corrupción de datos a nivel de red

Las conexiones de red inestables, los problemas del servidor Proxy y los problemas de resolución de DNS introducen una sutil corrupción de datos que es difícil de detectar a través de la gestión de errores estándar. Las descargas parciales de contenido crean respuestas HTML truncadas que se analizan correctamente pero que omiten secciones críticas de la página. Su Raspador podría recibir el primer 80% de una página de listado de productos, aparentando funcionar correctamente, pero omitiendo sistemáticamente elementos que se cargan en la parte inferior de páginas más largas.

Los algoritmos de compresión corrompen ocasionalmente los datos durante la transmisión, especialmente cuando se utilizan Proxies rotativos con diferentes ajustes de compresión.

¿Cuáles son las repercusiones de los datos inexactos en las aplicaciones?

Los datos de Scraping web inexactos afectan a los sistemas de maneras que comprometen fundamentalmente la lógica empresarial y las experiencias de los usuarios. Comprender estos fallos ayuda a los desarrolladores a construir canalizaciones de datos y capas de validación más resistentes.

Degradación de la canalización analítica

Los problemas de calidad de los datos se manifiestan de forma más visible en los sistemas analíticos, donde las agregaciones amplifican los errores subyacentes. Cuando los datos de precios de comercio electrónico raspados contienen errores de Parseo que convierten “29,99 $” en “2999” debido a fallos en el manejo de símbolos de moneda, los cálculos de precios medios pierden sentido.

Las uniones de bases de datos pueden fallar sin que usted lo sepa cuando los identificadores de productos raspados contienen caracteres Unicode invisibles o espacios en blanco al final. Un sistema de seguimiento de productos puede mostrar el mismo artículo como entradas separadas, lo que infla los recuentos de inventario y sesga los modelos de previsión de la demanda. Estos fallos de normalización estarán presentes en todos sus procesos ETL y provocarán que los informes posteriores dupliquen los ingresos.

Fallos del sistema de toma de decisiones

Los sistemas automatizados de toma de decisiones basados en datos raspados pueden tomar decisiones catastróficamente erróneas cuando se deteriora la calidad de la información. Las aplicaciones de Monitoreo de precios que se basan en datos de la competencia extraídos de sitios web dinámicos a menudo capturan valores de marcadores de posición como “Cargando…” o mensajes de error de JavaScript en lugar de precios reales. Cuando estas cadenas no numéricas eluden las capas de validación, los algoritmos de fijación de precios pueden pasar por defecto a valores cero.

Si está trabajando en un motor de recomendación, los Conjuntos de datos raspados están incompletos y algunas categorías de productos no se capturan sistemáticamente debido a problemas de paginación o barreras de autenticación. El sesgo de recomendación resultante hacia categorías raspadas con éxito crea cámaras de eco que reducen el descubrimiento de diversos productos por parte del cliente, limitando en última instancia el crecimiento de los ingresos y la satisfacción del cliente.

Degradación del rendimiento de las aplicaciones

Las aplicaciones que consumen datos raspados experimentan problemas de rendimiento cuando los problemas de calidad de los datos crean operaciones ineficaces en la base de datos. Los campos de texto scrapeados que contienen etiquetas HTML sin esconder pueden romper la indexación de la búsqueda, provocando exploraciones completas de la tabla en lugar de búsquedas optimizadas en el índice. La funcionalidad de búsqueda de cara al usuario deja de responder cuando estas penalizaciones de rendimiento se acumulan en varias consultas simultáneas.

Las estrategias de invalidación de caché fallan cuando los datos raspados contienen un formato incoherente que imposibilita la detección de duplicados. La misma información de producto raspada en diferentes momentos puede aparecer como entradas de caché separadas debido a la variación en la gestión de los espacios en blanco, lo que aumenta el uso de memoria y reduce las tasas de acierto de la caché. Esta contaminación de la caché obliga a las aplicaciones a realizar repetidas y costosas llamadas a la base de datos, lo que reduce la capacidad de respuesta general del sistema.

Problemas de integración de datos

Los datos raspados rara vez llegan aislados. Suelen unirse a bases de datos internas y API de terceros para crear Conjuntos de datos completos. Los desajustes de esquema son habituales cuando las estructuras de los campos raspados cambian inesperadamente debido a rediseños del sitio web. Un sistema de catálogo de productos puede perder especificaciones críticas cuando la lógica de raspado no se adapta a los nuevos diseños HTML, lo que deja a las aplicaciones posteriores con información incompleta sobre los productos que afecta a los resultados de las búsquedas y a las decisiones de compra de los clientes.

Las incoherencias en la frescura de los datos crean una situación en la que los datos raspados reflejan periodos de tiempo diferentes que los datos internos relacionados. Las aplicaciones financieras que combinan datos de mercado raspados con registros de transacciones internas pueden producir valoraciones de cartera incorrectas cuando los retrasos en el raspado hacen que la información de precios se retrase con respecto a las marcas de tiempo de las transacciones. Estas incoherencias temporales dificultan el establecimiento de rutas de auditoría precisas.

Diferentes formas de mejorar la precisión de los datos

La precisión de los datos en el Scraping web depende de la implementación de múltiples técnicas que trabajen juntas para abordar diferentes puntos de fallo en el proceso de extracción.

Gestión de contenidos dinámicos con navegadores sin encabezado

Los raspadores tradicionales basados en HTTP pierden partes sustanciales de los datos porque muchos sitios web dependen en gran medida de JavaScript para renderizar el contenido después de la carga inicial de la página. Los navegadores sin cabeza, como Puppeteer o Playwright, ejecutan JavaScript igual que los navegadores normales, lo que garantiza la captura de todo el contenido generado dinámicamente.

Puppeteer proporciona control sobre el renderizado de páginas a través de su integración con Chrome DevTools Protocol. Puede esperar a que se completen determinadas solicitudes de red, supervisar los cambios en el DOM e incluso interceptar las llamadas a la API que rellenan el contenido. Este enfoque resulta especialmente valioso para aplicaciones de una sola página que cargan datos a través de solicitudes AJAX después de la renderización inicial.

Cuando se utilicen navegadores headless, deshabilite las imágenes, CSS y plugins innecesarios para reducir el consumo de memoria y mejorar los tiempos de carga. Configure adecuadamente el tamaño de la ventana gráfica, ya que algunos sitios muestran contenidos diferentes en función de las dimensiones de la pantalla.

Adaptarse rápidamente a los cambios en la estructura de los sitios web

Las estructuras de los sitios web cambian con frecuencia y ponen en peligro los raspadores que se basan en selectores CSS fijos o expresiones XPath. La creación de raspadores adaptables requiere la aplicación de estrategias de emergencia y sistemas de supervisión que detecten los cambios estructurales antes de que provoquen la pérdida de datos.

Cree jerarquías de selectores que intenten varios enfoques para localizar el mismo elemento de datos. Empiece con el selector más específico y vaya recurriendo progresivamente a otros más generales.

clase AdaptiveSelector:

def __init__(self, lista_selectores, nombre_elemento):

self.selectores = lista_selectores

self.nombre_elemento = nombre_elemento

self.indice_exito = 0

def extraer_datos(self, sopa):

for i, selector in enumerate(self.selectors[self.successful_index:], self.successful_index):

elements = soup.select(selector)

si elementos:

self.successful_index = i

return [elem.get_text(strip=True) for elem in elements]

raise ValueError(f "No se ha encontrado ningún selector para {self.nombre_elemento}")

# Uso

selector_precios = AdaptiveSelector([

div.precio-actual .precio-valor', # Más específico

'.precio-actual', # Intermedio

'[class*="precio"]' # Retroceso amplio

], 'precio_producto')Implemente sistemas de detección de cambios que comparen las huellas digitales de la estructura de la página a lo largo del tiempo.

Validar y limpiar los datos raspados

Los datos raspados en bruto contienen muchas incoherencias que afectan a la precisión de sus datos. Para solucionarlo, es necesario implantar un proceso completo de validación y limpieza. Esto transforma los datos web desordenados en Conjuntos de datos fiables adecuados para el procesamiento posterior.

La validación de datos comienza con la comprobación de tipos y formatos. Los precios deben coincidir con los patrones de divisas, las fechas deben analizarse correctamente y los campos numéricos deben contener números válidos.

importar re

from datetime import datetime

from typing import Optional, Dict, Any

clase DataValidator:

def __init__(self):

self.patterns = {

'precio': re.compile(r'[$€£¥]?[d,]+.?d*'),

'email': re.compile(r'^[a-zA-Z0-9._%+-]+@[a-zA-Z0-9.-]+.[a-zA-Z]{2,}$'),

'phone': re.compile(r'^+?[ds-()]{10,}$'),

'date': re.compile(r'd{4}-d{2}-d{2}|d{2}/d{2}/d{4}')

}

def validate_record(self, record: Dict[str, Any]) -> Dict[str, Any]:

cleaned_record = {}

for campo, valor in registro.items():

si valor es None o str(valor).strip() == '':

registro_limpiado[campo] = None

continuar

valor_limpiado = self._clean_field(campo, str(valor))

if self._is_valid_field(field, cleaned_value):

registro_limpiado[campo] = valor_limpiado

else:

registro_limpiado[campo] = Ninguno

return registro_limpiado

def _clean_field(self, nombre_campo: str, valor: str) -> str:

# Elimina los espacios en blanco

cleaned = re.sub(r's+', ' ', value.strip())

# lógica de limpieza

devolver limpiado

def _is_valid_field(self, nombre_campo: str, valor: str) -> bool:

if 'precio' in nombre_campo.lower():

return bool(self.patterns['precio'].match(valor))

elif 'email' in nombre_campo.lower():

return bool(self.patterns['email'].match(value))

# Añadir más validaciones específicas de campo

return len(valor) > 0Implementar la detección de valores atípicos para identificar puntos de datos sospechosos que podrían indicar errores de raspado. Métodos estadísticos como el análisis del rango intercuartílico ayudan a detectar precios, cantidades u otros valores numéricos que se salen de los rangos esperados. Los algoritmos de similitud de cadenas pueden detectar campos de texto corruptos o errores de extracción.

Gestión de errores y reintentos

Los fallos de red, los errores del servidor y las excepciones de análisis son inevitables en las operaciones de Scraping web. La construcción de su Raspador web con una gestión integral de errores evita que los fallos individuales se conviertan en una cascada de averías completas del raspador, mientras que los mecanismos de reintento gestionan los problemas temporales de forma automática.

El retardo exponencial ofrece una estrategia eficaz para gestionar la limitación de velocidad y la sobrecarga temporal del servidor. Comienza con retardos cortos y aumenta progresivamente los tiempos de espera para los siguientes intentos de reintento. De este modo, los servidores tienen tiempo para recuperarse y se evitan patrones de reintento agresivos que podrían activar medidas anti-bot.

importar asyncio

import aiohttp

from typing import Optional, Callable

clase ResilientScraper:

def __init__(self, max_attempts=3, base_delay=1.0):

self.max_attempts = max_attempts

self.base_delay = base_delay

self.session = None

async def fetch_with_retry(self, url: str, parse_func: Callable) -> Optional[Any]:

for intento in rango(self.max_intentos):

try:

if intento > 0:

delay = self.base_delay * (2 ** attempt)

await asyncio.sleep(retardo)

async con self.session.get(url) como respuesta:

if response.status == 200:

content = await response.text()

return parse_func(contenido)

elif response.status == 429: # Tasa limitada

continuar

elif response.status >= 500: # Error del servidor

continue

else: # Error del cliente

return Ninguno

except (aiohttp.ClientError, asyncio.TimeoutError):

continue

return NoneLos patrones disyuntores evitan que los raspadores saturen los servicios que fallan. Realiza un seguimiento de las tasas de error de los dominios individuales y desactiva temporalmente las solicitudes cuando las tasas de fallo superan los umbrales aceptables. Este enfoque protege tanto a su Raspador como al sitio web de destino de cargas innecesarias durante las interrupciones.

Utilizar Proxies rotativos y agentes de usuario

El bloqueo de IP representa uno de los obstáculos más comunes en el Scraping web a gran escala. La rotación de proxies y agentes de usuario distribuye las solicitudes entre diferentes fuentes aparentes, lo que dificulta significativamente la detección a la vez que mantiene la velocidad de raspado.

Larotación de proxies requiere una gestión cuidadosa de los grupos de conexiones y la distribución de las solicitudes. Evite utilizar el mismo Proxy para peticiones consecutivas al mismo dominio, ya que este patrón sigue siendo detectable. En su lugar, implemente algoritmos de round-robin o de selección aleatoria que aseguren una distribución uniforme en su Proxy pool.

importar random

from typing import Lista, Dict, Opcional

clase ProxyRotator:

def __init__(self, proxies: List[str], user_agents: List[str]):

self.proxies = proxies

self.agentes_usuario = agentes_usuario

self.failed_proxies = set()

def get_next_proxy_and_headers(self) -> tupla[Opcional[cadena], Dict[cadena, cadena]]:

available_proxies = [p for p in self.proxies if p not in self.failed_proxies]

if not proxies_disponibles:

self.failed_proxies.clear()

proxies_disponibles = auto.proxies

Proxy = random.choice(proxies_disponibles)

user_agent = random.choice(self.user_agents)

cabeceras = {

'User-Agent': user_agent,

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8',

'Accept-Language': 'en-US,en;q=0.5',

'Connection': 'keep-alive'

}

return Proxy, cabeceras

def mark_proxy_failed(self, proxy: str):

self.failed_proxies.add(proxy)La rotación de agentes de usuario debe imitar las distribuciones realistas de navegadores encontradas en los datos de análisis web. Ponderar la lista de agentes de usuario según las estadísticas reales de cuota de mercado, asegurándose de que las variantes de Chrome aparezcan con más frecuencia que los navegadores menos comunes. Incluya agentes de usuario móviles para los sitios que sirven contenidos diferentes a los dispositivos móviles.

Gestión de Proxy basada en IA

Cuando se extraen datos, las prohibiciones de IP se convierten en un reto que puede detener sus operaciones por completo. Los sitios web pueden detectar fácilmente varias solicitudes procedentes de la misma dirección IP a gran velocidad, por lo que les resulta sencillo marcar y prohibir su raspador.

La solución reside en la gestión de proxies basada en IA, más que en la rotación básica de proxies. Este enfoque utiliza un conjunto de proxies para distribuir las solicitudes entre diferentes direcciones IP, enmascarando eficazmente su identidad. Servicios profesionales como Bright Data ofrecen acceso a más de 150 millones de IP residenciales de aproximadamente 195 países.

La gestión inteligente de proxies ofrece varias ventajas clave. Garantiza el anonimato para que los sitios web no puedan rastrear actividades sospechosas hasta usted directamente, e implementa una limitación dinámica de la tasa que ajusta la frecuencia de las solicitudes para imitar el comportamiento humano.

Estas estrategias se combinan para crear raspadores que mantienen la precisión de los datos en varios entornos web. Los navegadores sin cabeza capturan el contenido completo, los selectores adaptables gestionan los cambios estructurales, los canales de validación limpian los datos extraídos, la gestión integral de errores evita los fallos y la gestión de Proxy basada en IA optimiza la entrega.

Herramientas y mejores prácticas para un scraping fiable

La selección de la herramienta de scraping adecuada depende de la complejidad de los sitios web de destino y de sus requisitos de escalabilidad. Esta sección examina cuatro categorías de herramientas que abordan diferentes retos técnicos en el Scraping web.

Bibliotecas Python para contenido estático

Beautiful Soup destaca en el análisis sintáctico de documentos HTML cuyo contenido se carga directamente en la respuesta inicial del servidor. La biblioteca maneja HTML malformado con elegancia y proporciona métodos de navegación intuitivos para extraer datos de elementos anidados. Requests se empareja de forma natural con Beautiful Soup para manejar las propiedades del sitio que muchos sitios requieren para un acceso adecuado a los datos.

Scrapy funciona como un marco completo más que como una simple biblioteca. Gestiona peticiones concurrentes a través de su programador integrado y maneja escenarios de rastreo complejos a través de su arquitectura de canalización. Puede utilizar su sistema de middleware para el procesamiento de solicitudes personalizadas, la rotación de agentes de usuario y los mecanismos de reintento automático.

Automatización de navegadores para contenido dinámico

Selenium controla navegadores reales a través de protocolos WebDriver, por lo que es adecuado para sitios web que dependen en gran medida de la ejecución de JavaScript para la representación de contenidos. La herramienta gestiona las interacciones del usuario, como el envío de formularios, los clics en botones y la paginación de desplazamiento, que activan la carga de contenido adicional. Tendría que introducir explícitamente sus condiciones de espera para pausar la ejecución hasta que elementos específicos estén disponibles o cumplan determinados criterios.

Playwright proporciona capacidades similares de automatización del navegador con características de rendimiento mejoradas y manejo integrado de las funciones web modernas. La funcionalidad de espera automática de la herramienta elimina la mayoría de los problemas de tiempo al esperar automáticamente a que los elementos sean procesables antes de proceder con las interacciones. Las funciones de interceptación de red de Playwright permiten supervisar las llamadas a la API que rellenan el contenido de la página, lo que a menudo revela métodos de acceso a datos más eficaces que el análisis sintáctico del HTML renderizado.

Soluciones Headless Browser

Puppeteer se dirige específicamente a navegadores basados en Chromium y ofrece un buen control sobre el comportamiento del navegador a través de su integración con DevTools Protocol. La herramienta destaca en la generación de capturas de pantalla, PDF y métricas de rendimiento junto con la extracción de datos. Dispone de interceptación de peticiones que puedes utilizar para bloquear recursos innecesarios como imágenes y hojas de estilo y mejorar la velocidad de scraping para la extracción centrada en el contenido.

Playwright es una función multinavegador, lo que la hace valiosa para el scraping en diferentes motores de renderizado. La función codegen de la herramienta registra las interacciones del usuario y genera las secuencias de comandos de automatización correspondientes.

Plataformas empresariales de gestión de Proxy

Bright Data proporciona rotación de IP residenciales a través de ubicaciones globales con capacidades de persistencia de sesión que mantienen identidades consistentes a lo largo de las sesiones de scraping en múltiples páginas. El servicio Web Unlocker gestiona automáticamente las medidas anti-bot habituales, incluida la Resolución de CAPTCHA y la aleatorización de huellas dactilares del navegador. Su Navegador de scraping combina la rotación de proxy con instancias de navegador preconfiguradas y optimizadas para evitar la detección.

Gestión de solicitudes y limitación de velocidad

La implementación de estrategias de backoff evita la saturación de los servidores de destino al tiempo que gestiona los fallos temporales con elegancia. Por ejemplo, urllib3, uno de los principales clientes HTTP de Python, proporciona mecanismos de reintento con retardos configurables entre intentos. La limitación de velocidad personalizada mediante algoritmos de token bucket garantiza que el espaciado entre solicitudes se ajuste a la capacidad del servidor, en lugar de aplicar retardos fijos que pueden ser demasiado agresivos o insuficientes.

La gestión de sesiones puede ser importante para los sitios web que requieren autenticación o que mantienen el estado de las solicitudes. El almacenamiento persistente de cookies y la gestión de cabeceras garantizan que los raspadores mantengan el acceso a contenidos protegidos a lo largo de sesiones de raspado prolongadas. La agrupación de conexiones reduce la sobrecarga al reutilizar las conexiones de red establecidas en varias peticiones al mismo dominio.

Validación de datos

Las bibliotecas de validación de esquemas, como Pydantic, garantizan la coherencia de las estructuras de datos y detectan los errores de análisis antes de que se propaguen por los canales de procesamiento. Implementar la validación de sumas de comprobación para el contenido raspado ayuda a detectar cuándo los sitios web modifican su estructura o formato de contenido, activando alertas para el mantenimiento del raspador.

La elección entre estas herramientas depende de sus requisitos técnicos específicos. Por ejemplo, los raspadores de contenido estático ofrecen el máximo rendimiento para tareas de extracción sencillas, mientras que las herramientas de automatización de navegadores gestionan escenarios interactivos complejos a costa de un mayor consumo de recursos.

Conclusión

En este artículo hemos conocido los retos a los que se enfrentan los desarrolladores a la hora de extraer datos de sitios web y, a continuación, hemos identificado los resultados de un mal scraping. Por último, conocimos las herramientas y estrategias que pueden ayudar a resolver estos problemas.